系统性能优化

参考资料

影响性能的因素

只有4种资源对系统性能有显著影响:

CPU时间

vmstat , uptime , top , sar 可以帮助查看CPU负载

内存

硬盘I/O

iostat , sar 可以帮助查看磁盘负载

网络I/O

geminis@geminis-ubuntu:~$ sudo apt-cache search oprofile oprofile - system-wide profiler for Linux systems oprofile-gui - system-wide profiler for Linux systems (GUI components)

做什么可以提高性能

这是为了提高系统性能肯定能做的几件事情:

- 确保系统具有足够的内存。内存大小对系统性能有着主要的影响,目前内存价格是如此便宜,建议给每台重视性能的机器配置足够的内存。

- 复查系统和各个应用的配置。确保各个应用都能以多种方式进行调优,获得性能上的提升(如,数据分布在多个磁盘上,不要随时执行DNS查询)。

- 对于将linux应用于WEB服务器或其它类型的网络应用服务器的情况,前端添加负载均衡硬件或软件。

- 组织磁盘和文件系统以平衡负载,从而得到最大的I/O吞吐量。选择合适的Linux I/O调度方法,利用多磁盘技术(raid)优化数据传输。

Liunx下查看服务器性能

uptime命令

#uptime 00:59:34 up 20 days, 14:00, 2 user, load average: 0.55, 0.57, 0.84

上面命令显示示

最近1分钟内系统的平均负载是0.55,在最近5分钟内系统的平均负载是0.57,在最近的15分钟内系统的平均负载是0.84 一共两个用户。

cat /proc/loadavg命令

#cat /proc/loadavg 1.54 1.03 0.94 1/285 28156

返回数据的含义是:

1秒钟平均负载;5秒钟平均负载;15秒钟平均负载;总作业数;正在运行的作业总数。

cat /proc/stat命令

#cat /proc/stat cpu 119560393 366 75934979 491196419 22949796 273570 1653811 0 cpu0 24181069 1 18320054 132965211 2407486 3 18623 0 cpu1 27984558 11 21594016 126044599 2248274 0 20895 0 cpu2 27843845 349 21307705 116391192 12214581 35726 98960 0 cpu3 39550920 3 14713203 115795416 6079453 237839 1515332 0 intr 2741402899 1779118189 2 0 0 2 0 3 0 1 1 0 0 ctxt 7985896352 btime 1217386758 processes 1161591 procs_running 1 procs_blocked 0

返回的数据的含义如下:

前五行是CPU时间=user+system+nice+idle+iowait+irq+softirq(具体可以查看后面提供的备注)

“intr”这行给出中断的信息,第一个为自系统启动以来,发生的所有的中断的次数;

然后每个数对应一个特定的中断自系统启动以来所发生的次数。

“ctxt”给出了自系统启动以来CPU发生的上下文交换的次数。

“btime”给出了从系统启动到现在为止的时间,单位为秒。

“processes (total_forks) 自系统启动以来所创建的任务的个数目。

“procs_running”:当前运行队列的任务的数目。

“procs_blocked”:当前被阻塞的任务的数目。

备注

user+system+nice+idle+iowait+irq+softirq的含义是:1 jiffies=0.01秒 user 从系统启动开始累计到当前时刻,用户态的CPU时间(单位:jiffies) ,不包含 nice值为负进程。 nice 从系统启动开始累计到当前时刻,nice值为负的进程所占用的CPU时间(单位:jiffies) system 从系统启动开始累计到当前时刻,核心时间(单位:jiffies) idle 从系统启动开始累计到当前时刻,除硬盘IO等待时间以外其它等待时间(单位:jiffies) iowait 从系统启动开始累计到当前时刻,硬盘IO等待时间(单位:jiffies) irq 从系统启动开始累计到当前时刻,硬中断时间(单位:jiffies) softirq 从系统启动开始累计到当前时刻,软中断时间(单位:jiffies)

Load average的理解

系统平均负载被定义为在特定时间间隔内运行队列中的平均进程树。如果一个进程满足以下条件则其就会位于运行队列中:

- 它没有在等待I/O操作的结果

- 它没有主动进入等待状态(也就是没有调用’wait’)

- 没有被停止(例如:等待终止)

load average如何计算

为了使内核可以高效计算load average,采用了fixed-point arithmetic。

fixed-point arithmetic是一种非常快速的模拟浮点运算的方法,特别是在没有FPU(float point unit)部件的处理器上,非常有用。

计算公式:load(t) = load(t-1) e^(-5/60) + n (1 - e^(-5/60)),迭代计算,其中n为run-queue length。

由Exponential Smoothing方程有,Y(t)= Y(t-1) + a*[X(t) - Y(t-1)]

whereX(t)is the input raw data,Y(t-1) is the value due to the previoussmoothing iteration and Y(t) is the new smoothed value.

令a=1-b,b为e^(-5/60),就可以得到load average的计算公式。采用此公式的好处:局部的load抖动不会对load average造成重大影响,使其平滑。

load average释疑

一般来说只要每个CPU的当前活动进程数不大于2那么系统的性能就是良好的,如果每个CPU的任务数大于5,那么就表示这台机器的性能有严重问题。

假设系统有两个CPU,那么其每个CPU的当前任务数为:Load average/2。这时候取得的数值可以参照上述标准来进行判断

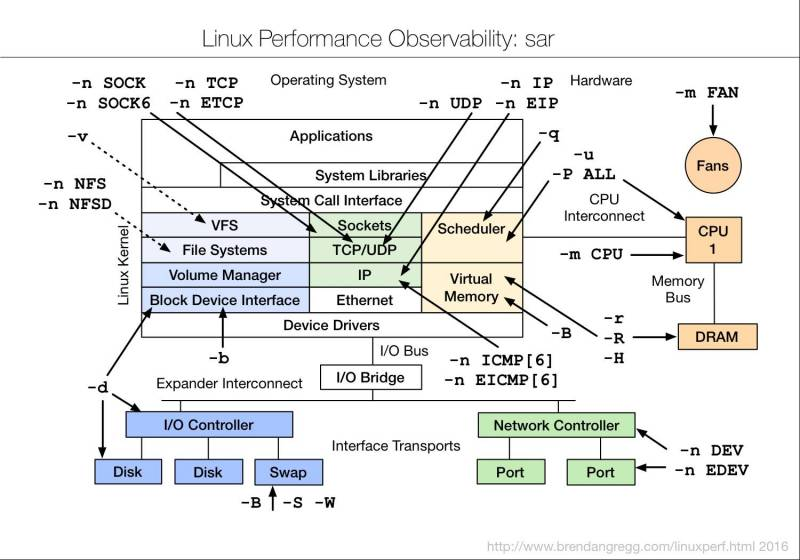

Linux下SAR命令用法

dmesg可以直接查看cpu的主频,要查看CPU、内存的使用情况可以使用sar!

sar 命令行的常用格式:

sar [options] [-A] [-o file] t [n]

在命令行中,n 和t 两个参数组合起来定义采样间隔和次数,t为采样间隔,是必须有的参数,n为采样次数,是可选的,默认值是1

-o file表示将命令结果以二进制格式存放在文件中,file 在此处不是关键字,是文件名。

options 为命令行选项,sar命令的选项很多,下面只列出常用选项:

-A:所有报告的总和。

-u:CPU利用率

-v:进程、I节点、文件和锁表状态。

-d:硬盘使用报告。

-r:没有使用的内存页面和硬盘块。

-g:串口I/O的情况。

-b:缓冲区使用情况。

-a:文件读写情况。

-c:系统调用情况。

-R:进程的活动情况。

-y:终端设备活动情况。

-w:系统交换活动。

下面将举例说明

例一:使用命令行 sar -u t n

例如,每60秒采样一次,连续采样5次,观察CPU 的使用情况,并将采样结果以二进制形式存入当前目录下的文件zhou中,需键入如下命令:

# sar -u -o zhou 60 5

屏幕显示:

SCO_SV scosysv 3.2v5.0.5 i80386 10/01/2001 14:43:50 %usr %sys %wio %idle(-u) 14:44:50 0 1 4 94 14:45:50 0 2 4 93 14:46:50 0 2 2 96 14:47:50 0 2 5 93 14:48:50 0 2 2 96 Average 0 2 4 94

在显示内容包括:

%usr:CPU处在用户模式下的时间百分比。 %sys:CPU处在系统模式下的时间百分比。 %wio:CPU等待输入输出完成时间的百分比。 %idle:CPU空闲时间百分比。

在所有的显示中,我们应主要注意%wio和%idle,%wio的值过高,表示硬盘存在I/O瓶颈,%idle值高,表示CPU较空闲,如果%idle值高但系统响应慢时,有可能是CPU等待分配内存,此时应加大内存容量。%idle值如果持续低于10,那么系统的CPU处理能力相对较低,表明系统中最需要解决的资源是CPU。

如果要查看二进制文件zhou中的内容,则需键入如下sar命令:

# sar -u -f zhou

可见,sar命令即可以实时采样,又可以对以往的采样结果进行查询。

例二:使用命行sar -v t n

例如,每30秒采样一次,连续采样5次,观察核心表的状态,需键入如下命令:

# sar -v 30 5

屏幕显示:

SCO_SV scosysv 3.2v5.0.5 i80386 10/01/2001 10:33:23 proc-sz ov inod-sz ov file-sz ov lock-sz (-v) 10:33:53 305/ 321 0 1337/2764 0 1561/1706 0 40/ 128 10:34:23 308/ 321 0 1340/2764 0 1587/1706 0 37/ 128 10:34:53 305/ 321 0 1332/2764 0 1565/1706 0 36/ 128 10:35:23 308/ 321 0 1338/2764 0 1592/1706 0 37/ 128 10:35:53 308/ 321 0 1335/2764 0 1591/1706 0 37/ 128

显示内容包括:

proc-sz:目前核心中正在使用或分配的进程表的表项数,由核心参数MAX-PROC控制。 inod-sz:目前核心中正在使用或分配的i节点表的表项数,由核心参数MAX-INODE控制。 file-sz: 目前核心中正在使用或分配的文件表的表项数,由核心参数MAX-FILE控制。 ov:溢出出现的次数。 Lock-sz:目前核心中正在使用或分配的记录加锁的表项数,由核心参数MAX-FLCKRE控制。

显示格式为

实际使用表项/可以使用的表项数

显示内容表示,核心使用完全正常,三个表没有出现溢出现象,核心参数不需调整,如果出现溢出时,要调整相应的核心参数,将对应的表项数加大。

例三:使用命行sar -d t n

例如,每30秒采样一次,连续采样5次,报告设备使用情况,需键入如下命令:

# sar -d 30 5

屏幕显示:

SCO_SV scosysv 3.2v5.0.5 i80386 10/01/2001 11:06:43 device %busy avque r+w/s blks/s avwait avserv (-d) 11:07:13 wd-0 1.47 2.75 4.67 14.73 5.50 3.14 11:07:43 wd-0 0.43 18.77 3.07 8.66 25.11 1.41 11:08:13 wd-0 0.77 2.78 2.77 7.26 4.94 2.77 11:08:43 wd-0 1.10 11.18 4.10 11.26 27.32 2.68 11:09:13 wd-0 1.97 21.78 5.86 34.06 69.66 3.35 Average wd-0 1.15 12.11 4.09 15.19 31.12 2.80

显示内容包括:

device: sar命令正在监视的块设备的名字。 %busy: 设备忙时,传送请求所占时间的百分比。 avque: 队列站满时,未完成请求数量的平均值。 r+w/s: 每秒传送到设备或从设备传出的数据量。 blks/s: 每秒传送的块数,每块512字节。 avwait: 队列占满时传送请求等待队列空闲的平均时间。 avserv: 完成传送请求所需平均时间(毫秒)。

在显示的内容中,wd-0是硬盘的名字,%busy的值比较小,说明用于处理传送请求的有效时间太少,文件系统效率不高,一般来讲,%busy值高些,avque值低些,文件系统的效率比较高,如果%busy和avque值相对比较高,说明硬盘传输速度太慢,需调整。

例四:使用命行sar -b t n

例如,每30秒采样一次,连续采样5次,报告缓冲区的使用情况,需键入如下命令:

# sar -b 30 5

屏幕显示:

SCO_SV scosysv 3.2v5.0.5 i80386 10/01/2001 14:54:59 bread/s lread/s %rcache bwrit/s lwrit/s %wcache pread/s pwrit/s (-b) 14:55:29 0 147 100 5 21 78 0 0 14:55:59 0 186 100 5 25 79 0 0 14:56:29 4 232 98 8 58 86 0 0 14:56:59 0 125 100 5 23 76 0 0 14:57:29 0 89 100 4 12 66 0 0 Average 1 156 99 5 28 80 0 0

显示内容包括:

bread/s: 每秒从硬盘读入系统缓冲区buffer的物理块数。 lread/s: 平均每秒从系统buffer读出的逻辑块数。 %rcache: 在buffer cache中进行逻辑读的百分比。 bwrit/s: 平均每秒从系统buffer向磁盘所写的物理块数。 lwrit/s: 平均每秒写到系统buffer逻辑块数。 %wcache: 在buffer cache中进行逻辑读的百分比。 pread/s: 平均每秒请求物理读的次数。 pwrit/s: 平均每秒请求物理写的次数。

在显示的内容中,最重要的是%cache和%wcache两列,它们的值体现着buffer的使用效率,%rcache的值小于90或者%wcache的值低于65,应适当增加系统buffer的数量,buffer数量由核心参数NBUF控制,使%rcache达到90左右,%wcache达到80左右。但buffer参数值的多少影响I/O效率,增加buffer,应在较大内存的情况下,否则系统效率反而得不到提高。

例五:使用命行sar -g t n

例如,每30秒采样一次,连续采样5次,报告串口I/O的操作情况,需键入如下命令:

# sar -g 30 5

屏幕显示:

SCO_SV scosysv 3.2v5.0.5 i80386 11/22/2001 17:07:03 ovsiohw/s ovsiodma/s ovclist/s (-g) 17:07:33 0.00 0.00 0.00 17:08:03 0.00 0.00 0.00 17:08:33 0.00 0.00 0.00 17:09:03 0.00 0.00 0.00 17:09:33 0.00 0.00 0.00 Average 0.00 0.00 0.00

显示内容包括:

ovsiohw/s: 每秒在串口I/O硬件出现的溢出。 ovsiodma/s:每秒在串口I/O的直接输入输出通道高速缓存出现的溢出。 ovclist/s :每秒字符队列出现的溢出。

在显示的内容中,每一列的值都是零,表明在采样时间内,系统中没有发生串口I/O溢出现象。

sar命令的用法很多,有时判断一个问题,需要几个sar命令结合起来使用,比如,怀疑CPU存在瓶颈,可用sar -u 和sar -q来看,怀疑I/O存在瓶颈,可用sar -b、sar -u和sar-d来看。

Sar

-A 所有的报告总和 -a 文件读,写报告 -B 报告附加的buffer cache使用情况 -b buffer cache使用情况 -c 系统调用使用报告 -d 硬盘使用报告 -g 有关串口I/O情况 -h 关于buffer使用统计数字 -m IPC消息和信号灯活动 -n 命名cache -p 调页活动 -q 运行队列和交换队列的平均长度 -R 报告进程的活动 -r 没有使用的内存页面和硬盘块 -u CPU利用率 -v 进程,i节点,文件和锁表状态 -w 系统交换活动 -y TTY设备活动

-a 报告文件读,写报告

sar –a 5 5 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/07/2002 11:45:40 iget/s namei/s dirbk/s (-a) 11:45:45 6 2 2 11:45:50 91 20 28 11:45:55 159 20 18 11:46:00 157 21 19 11:46:05 177 30 35 Average 118 18 20

iget/s 每秒由i节点项定位的文件数量 namei/s 每秒文件系统路径查询的数量 dirbk/s 每秒所读目录块的数量

-b 报告缓冲区(buffer cache)的使用情况

sar -b 2 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/07/2002 13:51:28 bread/s lread/s %rcache bwrit/s lwrit/s %wcache pread/s pwrit/s (-b) 13:51:30 382 1380 72 131 273 52 0 0 13:51:32 378 516 27 6 22 72 0 0 13:51:34 172 323 47 39 57 32 0 0 Average 310 739 58 58 117 50 0 0

bread/s 平均每秒从硬盘(或其它块设备)读入系统buffer的物理块数 lread/s 平均每秒从系统buffer读出的逻辑块数 %rcache 在buffer cache中进行逻辑读的百分比(即100% - bread/lreads) bwrit/s 平均每秒从系统buffer向磁盘(或其它块设备)所写的物理块数 lwrit/s 平均每秒写到系统buffer的逻辑块数 %wcache 在buffer cache中进行逻辑写的百分比(即100% - bwrit/lwrit). pread/sgu 平均每秒请求进行物理读的次数 pwrit/s 平均每秒请求进行物理写的次数

-c 报告系统调用使用情况

sar -c 2 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/07/2002 17:02:42 scall/s sread/s swrit/s fork/s exec/s rchar/s wchar/s (-c) 17:02:44 2262 169 141 0.00 0.00 131250 22159 17:02:46 1416 61 38 0.00 0.00 437279 6464 17:02:48 1825 43 25 0.00 0.00 109397 42331 Average 1834 91 68 0.00 0.00 225975 23651

scall/s 每秒使用系统调用的总数。一般地,当4~6个用户在系统上工作时,每秒大约30个左右。 sread/s 每秒进行读操作的系统调用数量。 swrit/s 每秒进行写操作的系统调用数量。 fork/s 每秒fork系统调用次数。当4~6个用户在系统上工作时,每秒大约0.5秒左右。 exec/s 每秒exec系统调用次数。 rchar/s 每秒由读操作的系统调用传送的字符(以字节为单位)。 wchar/s 每秒由写操作的系统调用传送的字符(以字节为单位)。

-d 报告硬盘使用情况

sar -d 2 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/07/2002 17:27:49 device %busy avque r+w/s blks/s avwait avserv (-d) 17:27:51 ida-0 6.93 1.00 13.86 259.41 0.00 5.00 ida-1 0.99 1.00 17.33 290.10 0.00 0.57 17:27:53 ida-0 75.50 1.00 54.00 157.00 0.00 13.98 ida-1 9.50 1.00 12.00 75.00 0.00 7.92 17:27:55 ida-0 7.46 1.00 46.77 213.93 0.00 1.60 ida-1 17.41 1.00 57.71 494.53 0.00 3.02 Average ida-0 29.85 1.00 38.14 210.28 0.00 7.83 ida-1 9.29 1.00 29.02 286.90 0.00 3.20

device 这是sar命令正在监视的块设备的名字。 %busy 设备忙时,运行传送请求所占用的时间。这个值以百分比表示。 avque 在指定的时间周期内,没有完成的请求数量的平均值。仅在队列被占满时取这个值。 r+w/s 每秒传送到设备或者从设备传送出的数据量。 blks/s 每秒传送的块数。每块512个字节。 avwait 传送请求等待队列空闲的平均时间(以毫秒为单位)。仅在队列被占满时取这个值。 avserv 完成传送请求所需平均时间(以毫秒为单位)

-g 报告有关串口I/O情况

sar -g 3 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/13/2002 11:10:09 ovsiohw/s ovsiodma/s ovclist/s (-g) 11:10:12 0.00 0.00 0.00 11:10:15 0.00 0.00 0.00 11:10:18 0.00 0.00 0.00 Average 0.00 0.00 0.00

ovsiohw/s 每秒在串囗I/O硬件出现的溢出。 ovsiodma/s 每秒在串囗I/O的直接输入,输出信道高速缓存出现的溢出。 ovclist/s 每秒字符队列出现的溢出。

-m 报告进程间的通信活动(IPC消息和信号灯活动)情况

sar -m 4 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/13/2002 13:24:28 msg/s sema/s (-m) 13:24:32 2.24 9.95 13:24:36 2.24 21.70 13:24:40 2.00 36.66 Average 2.16 22.76

msg/s 每秒消息操作的次数(包括发送消息的接收信息)。 sema/s 每秒信号灯操作次数。

-n 报告命名缓冲区活动情况

sar -n 4 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/13/2002 13:37:31 c_hits cmisses (hit %) (-n) 13:37:35 1246 71 (94%) 13:37:39 1853 81 (95%) 13:37:43 969 56 (94%) Average 1356 69 (95%)

c_hits cache命中的数量。 cmisses cache未命中的数量。 (hit %) 命中数量/(命中数理+未命中数量)。

-p 报告分页活动

sar -p 5 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/13/2002 13:45:26 vflt/s pflt/s pgfil/s rclm/s (-p) 13:45:31 36.25 50.20 0.00 0.00 13:45:36 32.14 58.48 0.00 0.00 13:45:41 79.80 58.40 0.00 0.00 Average 49.37 55.69 0.00 0.00

vflt/s 每秒进行页面故障地址转换的数量(由于有效的页面当前不在内存中)。 pflt/s 每秒来自由于保护错误出现的页面故障数量(由于对页面的非法存,取引起的页面故障)。 pgfil/s 每秒通过”页—入”满足vflt/s的数量。 rclm/s 每秒由系统恢复的有效页面的数量。有效页面被增加到自由页面队列上。

-q 报告进程队列(运行队列和交换队列的平均长度)情况

sar -q 2 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/13/2002 14:25:50 runq-sz %runocc swpq-sz %swpocc (-q) 14:25:52 4.0 50 14:25:54 9.0 100 14:25:56 9.0 100 Average 7.3 100

runq-sz 准备运行的进程运行队列。 %runocc 运行队列被占用的时间(百分比) swpq-sz 要被换出的进程交换队列。 %swpocc 交换队列被占用的时间(百分比)。

-r 报告内存及交换区使用情况(没有使用的内存页面和硬盘块)

sar -r 2 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/14/2002 10:14:19 freemem freeswp availrmem availsmem (-r) 10:14:22 279729 6673824 93160 1106876 10:14:24 279663 6673824 93160 1106876 10:14:26 279661 6673824 93160 1106873 Average 279684 6673824 93160 1106875

freemem 用户进程可以使用的内存页面数,4KB为一个页面。 freeswp 用于进程交换可以使用的硬盘盘块,512B为一个盘块。

-u CPU利用率

sar -u 2 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/14/2002 10:27:23 %usr %sys %wio %idle (-u) 10:27:25 2 3 8 88 10:27:27 3 3 5 89 10:27:29 0 0 0 100 Average 2 2 4 92

%usr cpu处在用户模式下时间(百分比) %sys cpu处在系统模式下时间(百分比) %wio cpu等待输入,输出完成(时间百分比) %idle cpu空闲时间(百分比)

-v 报告系统表的内容(进程,i节点,文件和锁表状态)

sar -v 2 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/14/2002 10:56:46 proc-sz ov inod-sz ov file-sz ov lock-sz (-v) 10:56:48 449/ 500 0 994/4147 0 1313/2048 0 5/ 128 10:56:50 450/ 500 0 994/4147 0 1314/2048 0 5/ 128 10:56:52 450/ 500 0 994/4147 0 1314/2048 0 5/ 128

proc-sz 目前在核心中正在使用或分配的进程表的表项数 inod-sz 目前在核心中正在使用或分配的i节点表的表项数 file-sz 目前在核心中正在使用或分配的文件表的表项数 ov 溢出出现的次数 lock-sz 目前在核心中正在使用或分配的记录加锁的表项数

- 除ov外,均涉及到unix的核心参数,它们分别受核心参数NPROC,NIMODE,NFILE和FLOCKREC的控制。

显示格式为:

实际使用表项/整个表可以使用的表项数

比如,proc-sz一列所显示的四个数字中,分母的100是系统中整个进程表的长度(可建立100个表项),分子上的24,26和25分别是采样的那一段时间所使用的进程表项。inod-sz,file-sz和lock-sz三列数字的意义也相同。三列ov的值分别对应进程表,i节点表和文件表,表明目前这三个表都没有出现溢出现象,当出现溢出时,需要调整相应的核心参数,将对应表加大。

-w 系统交换活动

sar -w 2 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/14/2002 11:22:05 swpin/s bswin/s swpot/s bswots pswch/s (-w) 11:22:07 0.00 0.0 0.00 0.0 330 11:22:09 0.00 0.0 0.00 0.0 892 11:22:11 0.00 0.0 0.00 0.0 1053 Average 0.00 0.0 0.00 0.0 757

swpin/s 每秒从硬盘交换区传送进入内存的次数。 bswin/s 每秒为换入而传送的块数。 swpot/s 每秒从内存传送到硬盘交换区的次数。 bswots 每秒为换出而传送的块数。 pswch/s 每秒进程交换的数量。

-y 报告终端的I/O活动(TTY设备活动)情况

sar -y 2 3 SCO_SV scosvr 3.2v5.0.5 PentII(D)ISA 06/14/2002 11:38:03 rawch/s canch/s outch/s rcvin/s xmtin/s mdmin/s (-y) 11:38:05 5 0 951 0 1 0 11:38:07 10 0 996 0 0 0 11:38:09 4 0 2264 0 0 0 Average 6 0 1404 0 1 0

rawch/s 每秒输入的字符数(原始队列) canch/s 每秒由正则队列(canonical queue)处理的输入字符数。 进行正则处理过程中,可以识别出一些有特殊意义的字符。比如,(中断字符),(退出符),(退格键)等。 因此,canch/s中的计数不包括这些有特殊意义的字符。 outch/s 每秒输出的字符数。 rcvin/s 每秒接收的硬件中断次数。 xmtin/s 每秒发出的硬件中断次数。 mdmin/s 每秒modem中断次数。

系统性能调整

/proc目录优化

本文档针对OOP8生产环境,具体优化策略需要根据实际情况进行调整;本文档将在以下几个方面来阐述如何针对RedHat Enterprise Linux进行性能优化。

1) Linux Proc文件系统,通过对Proc文件系统进行调整,达到性能优化的目的。 2) Linux性能诊断工具,介绍如何使用Linux自带的诊断工具进行性能诊断。

加粗斜体表示可以直接运行的命令。 下划线表示文件的内容。

/proc/sys/kernel/优化

1) /proc/sys/kernel/ctrl-alt-del

该文件有一个二进制值,该值控制系统在接收到ctrl+alt+delete按键组合时如何反应。这两个值分别是:

零(0)值,表示捕获ctrl+alt+delete,并将其送至 init 程序;

这将允许系统可以安全地关闭和重启,就好象输入shutdown命令一样。

壹(1)值,表示不捕获ctrl+alt+delete,将执行非正常的关闭,就好象直接关闭电源一样。

缺省设置:0

建议设置:1,防止意外按下ctrl+alt+delete导致系统非正常重启。

2) proc/sys/kernel/msgmax 该文件指定了从一个进程发送到另一个进程的消息的最大长度(bytes)。 进程间的消息传递是在内核内存中进行,不会交换到磁盘上,所以如果增加该值,将增加系统所使用的内存数量 缺省设置:8192

3) /proc/sys/kernel/msgmnb 该文件指定一个消息队列的最大长度(bytes)。 缺省设置:16384

4) /proc/sys/kernel/msgmni 该文件指定消息队列标识的最大数目,即系统范围内最大多少个消息队列。 缺省设置:16

5) /proc/sys/kernel/panic 该文件表示如果发生“内核严重错误(kernel panic)”,则内核在重新引导之前等待的时间(以秒为单位)。 零(0)秒,表示在发生内核严重错误时将禁止自动重新引导。 缺省设置:0

6) proc/sys/kernel/shmall 该文件表示在任何给定时刻,系统上可以使用的共享内存的总量(bytes)。 缺省设置:2097152

7) /proc/sys/kernel/shmmax 该文件表示内核所允许的最大共享内存段的大小(bytes)。 缺省设置:33554432 建议设置:物理内存 * 50% 实际可用最大共享内存段大小=shmmax * 98%,其中大约2%用于共享内存结构。 可以通过设置shmmax,然后执行ipcs -l来验证。

8) /proc/sys/kernel/shmmni 该文件表示用于整个系统的共享内存段的最大数目(个)。 缺省设置:4096

9) /proc/sys/kernel/threads-max 该文件表示内核所能使用的线程的最大数目。 缺省设置:2048

10) /proc/sys/kernel/sem 该文件用于控制内核信号量,信号量是System VIPC用于进程间通讯的方法。 建议设置:250 32000 100 128 第一列,表示每个信号集中的最大信号量数目。 第二列,表示系统范围内的最大信号量总数目。 第三列,表示每个信号发生时的最大系统操作数目。 第四列,表示系统范围内的最大信号集总数目。 所以,(第一列)*(第四列)=(第二列) 以上设置,可以通过执行ipcs -l来验证。

11) 待续...

/proc/sys/vm/优化

1) /proc/sys/vm/block_dump 该文件表示是否打开Block Debug模式,用于记录所有的读写及Dirty Block写回动作。

缺省设置:0,禁用Block Debug模式

2) /proc/sys/vm/dirty_background_ratio 该文件表示脏数据到达系统整体内存的百分比,此时触发pdflush进程把脏数据写回磁盘。

缺省设置:10

3) /proc/sys/vm/dirty_expire_centisecs 该文件表示如果脏数据在内存中驻留时间超过该值,pdflush进程在下一次将把这些数据写回磁盘。

缺省设置:3000(1/100秒)

4) /proc/sys/vm/dirty_ratio 该文件表示如果进程产生的脏数据到达系统整体内存的百分比,此时进程自行把脏数据写回磁盘。

缺省设置:40

5) /proc/sys/vm/dirty_writeback_centisecs 该文件表示pdflush进程周期性间隔多久把脏数据写回磁盘。

缺省设置:500(1/100秒)

6) /proc/sys/vm/vfs_cache_pressure 该文件表示内核回收用于directory和inode cache内存的倾向; 表示内核将根据pagecache和swapcache,把directory和inode cache保持在一个合理的百分比; 降低该值低于100,将导致内核倾向于保留directory和inode cache; 增加该值超过100,将导致内核倾向于回收directory和inode cache。

缺省设置:100

7) /proc/sys/vm/min_free_kbytes 该文件表示强制Linux VM最低保留多少空闲内存(Kbytes)。

缺省设置:724(512M物理内存)

8) /proc/sys/vm/nr_pdflush_threads 该文件表示当前正在运行的pdflush进程数量,在I/O负载高的情况下,内核会自动增加更多的pdflush进程。

缺省设置:2(只读)

9) /proc/sys/vm/overcommit_memory

该文件指定了内核针对内存分配的策略,其值可以是0、1、2。

0, 表示内核将检查是否有足够的可用内存供应用进程使用;如果有足够的可用内存,内存申请允许;

否则,内存申请失败,并把错误返回给应用进程。

1, 表示内核允许分配所有的物理内存,而不管当前的内存状态如何。

2, 表示内核允许分配超过所有物理内存和交换空间总和的内存(参照overcommit_ratio)。

缺省设置:0

10) /proc/sys/vm/overcommit_ratio 该文件表示,如果overcommit_memory=2,可以过载内存的百分比,通过以下公式来计算系统整体可用内存 系统可分配内存=交换空间+物理内存*overcommit_ratio/100

缺省设置:50(%)

11) /proc/sys/vm/page-cluster 该文件表示在写一次到swap区的时候写入的页面数量,0表示1页,1表示2页,2表示4页。

缺省设置:3(2的3次方,8页)

12) /proc/sys/vm/swapiness 该文件表示系统进行交换行为的程度,数值(0-100)越高,越可能发生磁盘交换。

缺省设置:60

13) legacy_va_layout 该文件表示是否使用最新的32位共享内存mmap()系统调用。 Linux支持的共享内存分配方式包括mmap(),Posix,System VIPC。 0, 使用最新32位mmap()系统调用。 1, 使用2.4内核提供的系统调用。

缺省设置:0

14) nr_hugepages 该文件表示系统保留的hugetlb页数。

15) hugetlb_shm_group 该文件表示允许使用hugetlb页创建System VIPC共享内存段的系统组ID。

16) 待续。。。

/proc/sys/fs/优化

1) /proc/sys/fs/file-max 该文件指定了可以分配的文件句柄的最大数目。如果用户得到的错误消息声明由于打开 文件数已经达到了最大值,从而他们不能打开更多文件,则可能需要增加该值。

缺省设置:4096 建议设置:65536

2) /proc/sys/fs/file-nr 该文件与 file-max 相关,它有三个值: 已分配文件句柄的数目 已使用文件句柄的数目 文件句柄的最大数目 该文件是只读的,仅用于显示信息。

3) 待续。。。

/proc/sys/net/core/优化

如果ping值是50ms,端到端的网络全部由100M以太网组成,那么TCP缓冲的大小应该是:

0.05 sec * (100 Mbits / 8 bits) = 625 KBytes

该目录下的配置文件主要用来控制内核和网络层之间的交互行为。

1) /proc/sys/net/core/message_burst 写新的警告消息所需的时间(以 1/10 秒为单位);在这个时间内系统接收到的其它警告消息会被丢弃。 这用于防止某些企图用消息“淹没”系统的人所使用的拒绝服务(Denial of Service)攻击。

缺省设置:50(5秒)

2) /proc/sys/net/core/message_cost 该文件表示写每个警告消息相关的成本值。该值越大,越有可能忽略警告消息。

缺省设置:5

3) /proc/sys/net/core/netdev_max_backlog 该文件表示在每个网络接口接收数据包的速率比内核处理这些包的速率快时,允许送到队列的数据包的最大数目。

缺省设置:300

4) /proc/sys/net/core/optmem_max 该文件表示每个套接字所允许的最大缓冲区的大小。

缺省设置:10240

5) /proc/sys/net/core/rmem_default 该文件指定了接收套接字缓冲区大小的缺省值(以字节为单位)。

缺省设置:110592

6) /proc/sys/net/core/rmem_max 该文件指定了接收套接字缓冲区大小的最大值(以字节为单位)。

缺省设置:131071

7) /proc/sys/net/core/wmem_default 该文件指定了发送套接字缓冲区大小的缺省值(以字节为单位)。

缺省设置:110592

8) /proc/sys/net/core/wmem_max 该文件指定了发送套接字缓冲区大小的最大值(以字节为单位)。

缺省设置:131071

9) 待续。。。

net.core.dev_weight = 4000 net.core.netdev_budget = 4000 net.core.netdev_max_backlog = 8000 #进入包的最大设备队列.默认是300,对重负载服务器而言,可调整到1000. net.core.optmem_max = 20480 #该文件表示每个套接字所允许的最大缓冲区的大小。 net.core.rmem_max = 16777216 #该文件指定了接收套接字缓冲区大小的最大值(以字节为单位)。 net.core.wmem_max = 16777216 #该文件指定了发送套接字缓冲区大小的最大值(以字节为单位)。 net.core.somaxconn = 1024 #listen()默认参数,挂起请求的最大数量.默认128.对繁忙的服务器,增加该值有助于网络性能.

/proc/sys/net/ipv4/优化

1) /proc/sys/net/ipv4/ip_forward 该文件表示是否打开IP转发。 0,禁止 1,转发 缺省设置:0

2) /proc/sys/net/ipv4/ip_default_ttl 该文件表示一个数据报的生存周期(Time To Live),即最多经过多少路由器。 缺省设置:64 增加该值会降低系统性能。

3) /proc/sys/net/ipv4/ip_no_pmtu_disc 该文件表示在全局范围内关闭路径MTU探测功能。 缺省设置:0

4) /proc/sys/net/ipv4/route/min_pmtu 该文件表示最小路径MTU的大小。 缺省设置:552

5) /proc/sys/net/ipv4/route/mtu_expires 该文件表示PMTU信息缓存多长时间(秒)。 缺省设置:600(秒)

6) /proc/sys/net/ipv4/route/min_adv_mss 该文件表示最小的MSS(Maximum Segment Size)大小,取决于第一跳的路由器MTU。 缺省设置:256(bytes)

6.1 IP Fragmentation 1) /proc/sys/net/ipv4/ipfrag_low_thresh/proc/sys/net/ipv4/ipfrag_low_thresh 两个文件分别表示用于重组IP分段的内存分配最低值和最高值,一旦达到最高内存分配值, 其它分段将被丢弃,直到达到最低内存分配值。 缺省设置:196608(ipfrag_low_thresh) 262144(ipfrag_high_thresh)

2) /proc/sys/net/ipv4/ipfrag_time 该文件表示一个IP分段在内存中保留多少秒。 缺省设置:30(秒)

6.2 INET Peer Storage 1) /proc/sys/net/ipv4/inet_peer_threshold INET对端存储器某个合适值,当超过该阀值条目将被丢弃。 该阀值同样决定生存时间以及废物收集通过的时间间隔。条目越多,存活期越低,GC 间隔越短。 缺省设置:65664

2) /proc/sys/net/ipv4/inet_peer_minttl 条目的最低存活期。在重组端必须要有足够的碎片(fragment)存活期。 这个最低存活期必须保证缓冲池容积是否少于 inet_peer_threshold。 缺省设置:120

3) /proc/sys/net/ipv4/inet_peer_maxttl 条目的最大存活期。在此期限到达之后,如果缓冲池没有耗尽压力的话,不使用的条目将会超时。 缺省设置:600

4) /proc/sys/net/ipv4/inet_peer_gc_mintime 废物收集(GC)通过的最短间隔。这个间隔会影响到缓冲池中内存的高压力。 该值以 jiffies为单位测量。 缺省设置:10

5) /proc/sys/net/ipv4/inet_peer_gc_maxtime 废物收集(GC)通过的最大间隔,这个间隔会影响到缓冲池中内存的低压力。 该值以 jiffies为单位测量。 缺省设置:120

6.3 TCP Variables 1) /proc/sys/net/ipv4/tcp_syn_retries 该文件表示本机向外发起TCP SYN连接超时重传的次数,不应该高于255; 该值仅仅针对外出的连接,对于进来的连接由tcp_retries1控制。 缺省设置:5

2) /proc/sys/net/ipv4/tcp_keepalive_probes 该文件表示丢弃TCP连接前,进行最大TCP保持连接侦测的次数。 保持连接仅在SO_KEEPALIVE套接字选项被打开时才被发送。 缺省设置:9(次)

3) /proc/sys/net/ipv4/tcp_keepalive_time 该文件表示从不再传送数据到向连接上发送保持连接信号之间所需的秒数。 缺省设置:7200(2小时)

4) /proc/sys/net/ipv4/tcp_keepalive_intvl 该文件表示发送TCP探测的频率,乘以tcp_keepalive_probes表示断开没有相应的TCP连接的时间。 缺省设置:75(秒)

5) /proc/sys/net/ipv4/tcp_retries1 该文件表示放弃回应一个TCP连接请求前进行重传的次数。

缺省设置:3

6) /proc/sys/net/ipv4/tcp_retries2

该文件表示放弃在已经建立通讯状态下的一个TCP数据包前进行重传的次数。 缺省设置:15

7) /proc/sys/net/ipv4/tcp_orphan_retries 在近端丢弃TCP连接之前,要进行多少次重试。默认值是 7 个,相当于 50秒–16分钟,视 RTO 而定。 如果您的系统是负载很大的web服务器,那么也许需要降低该值,这类 sockets 可能会耗费大量的资源。 另外参考tcp_max_orphans。 8) /proc/sys/net/ipv4/tcp_fin_timeout 对于本端断开的socket连接,TCP保持在FIN-WAIT-2状态的时间。 对方可能会断开连接或一直不结束连接或不可预料的进程死亡。默认值为 60 秒。 过去在2.2版本的内核中是 180 秒。您可以设置该值,但需要注意,如果您的机器为负载很重的web服务器, 您可能要冒内存被大量无效数据报填满的风险,FIN-WAIT-2 sockets 的危险性低于 FIN-WAIT-1, 因为它们最多只吃 1.5K的内存,但是它们存在时间更长。另外参考 tcp_max_orphans。 缺省设置:60(秒) 9) /proc/sys/net/ipv4/tcp_max_tw_buckets 系统在同时所处理的最大timewait sockets 数目。 如果超过此数的话,time-wait socket 会被立即砍除并且显示警告信息。 之所以要设定这个限制,纯粹为了抵御那些简单的 DoS 攻击,千万不要人为的降低这个限制, 不过,如果网络条件需要比默认值更多,则可以提高它(或许还要增加内存)。 缺省设置:180000 10) /proc/sys/net/ipv4/tcp_tw_recyle

打开快速 TIME-WAIT sockets 回收。除非得到技术专家的建议或要求,请不要随意修改这个值。

缺省设置:0

11) /proc/sys/net/ipv4/tcp_tw_reuse 该文件表示是否允许重新应用处于TIME-WAIT状态的socket用于新的TCP连接。 缺省设置:0

12) /proc/sys/net/ipv4/tcp_max_orphans 系统所能处理不属于任何进程的TCP sockets最大数量。 假如超过这个数量,那么不属于任何进程的连接会被立即reset,并同时显示警告信息。 之所以要设定这个限制,纯粹为了抵御那些简单的 DoS 攻击,千万不要依赖这个或是人为的降低这个限制。 缺省设置:8192

13) /proc/sys/net/ipv4/tcp_abort_on_overflow 当守护进程太忙而不能接受新的连接,就向对方发送reset消息,默认值是false。 这意味着当溢出的原因是因为一个偶然的猝发, 那么连接将恢复状态。 只有在你确信守护进程真的不能完成连接请求时才打开该选项,该选项会影响客户的使用。 缺省设置:0

14) /proc/sys/net/ipv4/tcp_syncookies 该文件表示是否打开TCP同步标签(syncookie),内核必须打开了 CONFIG_SYN_COOKIES项进行编译。 同步标签(syncookie)可以防止一个套接字在有过多试图连接到达时引起过载。 缺省设置:0

15) /proc/sys/net/ipv4/tcp_stdurg 使用 TCP urg pointer 字段中的主机请求解释功能。大部份的主机都使用老旧的BSD解释, 因此如果您在 Linux 打开它,或会导致不能和它们正确沟通。 缺省设置:0

16) /proc/sys/net/ipv4/tcp_max_syn_backlog 对于那些依然还未获得客户端确认的连接请求,需要保存在队列中最大数目。 对于超过128Mb内存的系统,默认值是1024,低于 128Mb 的则为 128。 如果服务器经常出现过载,可以尝试增加这个数字。警告!假如您将此值设为大于1024, 最好修改 include/net/tcp.h里面的 TCP_SYNQ_HSIZE。 缺省设置:1024

17) /proc/sys/net/ipv4/tcp_window_scaling 该文件表示设置tcp/ip会话的滑动窗口大小是否可变。 参数值为布尔值,为1时表示可变,为0时表示不可变。 tcp/ip通常使用的窗口最大可达到 65535 字节,对于高速网络,该值可能太小,这时候如果启用了该功能, 可以使tcp/ip滑动窗口大小增大数个数量级,从而提高数据传输的能力。 缺省设置:1

18) /proc/sys/net/ipv4/tcp_sack 该文件表示是否启用有选择的应答,这可以通过有选择地应答乱序接收到的报文来提高性能 (这样可以让发送者只发送丢失的报文段);对于广域网通信来说,这个选项应该启用,但是这会增加对 CPU 的占用。 缺省设置:1

19) /proc/sys/net/ipv4/tcp_timestamps 该文件表示是否启用以一种比超时重发更精确的方法(请参阅 RFC 1323)来启用对 RTT 的计算; 为了实现更好的性能应该启用这个选项。 缺省设置:1

20) /proc/sys/net/ipv4/tcp_fack 该文件表示是否打开FACK拥塞避免和快速重传功能。 缺省设置:1

21) /proc/sys/net/ipv4/tcp_dsack 该文件表示是否允许TCP发送“两个完全相同”的SACK。 缺省设置:1

22) /proc/sys/net/ipv4/tcp_ecn 该文件表示是否打开TCP的直接拥塞通告功能。 缺省设置:0

23) /proc/sys/net/ipv4/tcp_reordering 该文件表示TCP流中重排序的数据报最大数量。 缺省设置:3

24) /proc/sys/net/ipv4/tcp_retrans_collapse 该文件表示对于某些有bug的打印机是否提供针对其bug的兼容性。 缺省设置:1

25) /proc/sys/net/ipv4/tcp_wmem

该文件包含3个整数值,分别是:min,default,max

Min:为TCP socket预留用于发送缓冲的内存最小值。每个TCP socket都可以使用它。

Default:为TCP socket预留用于发送缓冲的内存数量。

默认情况下该值会影响其它协议使用的net.core.wmem中default的值,一般要低于

net.core.wmem中default的值。

Max:为TCP socket预留用于发送缓冲的内存最大值。该值不会影响net.core.wmem_max,

今天选择参数SO_SNDBUF则不受该值影响。默认值为128K。

缺省设置:4096 16384 131072

26) /proc/sys/net/ipv4/tcp_rmem

该文件包含3个整数值,分别是:min,default,max

Min: 为TCP socket预留用于接收缓冲的内存数量,

即使在内存出现紧张情况下TCP socket都至少会有这么多数量的内存用于接收缓冲。

Default:为TCP socket预留用于接收缓冲的内存数量。

默认情况下该值影响其它协议使用的 net.core.wmem中default的值。

该值决定了在tcp_adv_win_scale、tcp_app_win和tcp_app_win的默认值情况下,TCP 窗口大小为65535。

Max: 为TCP socket预留用于接收缓冲的内存最大值。该值不会影响 net.core.wmem中max的值,

今天选择参数 SO_SNDBUF则不受该值影响。

缺省设置:4096 87380 174760

27) /proc/sys/net/ipv4/tcp_mem

该文件包含3个整数值,分别是:low,pressure,high

Low:当TCP使用了低于该值的内存页面数时,TCP不会考虑释放内存。

Pressure:当TCP使用了超过该值的内存页面数量时,TCP试图稳定其内存使用,进入pressure模式。

当内存消耗低于low值时则退出pressure状态。

High: 允许所有tcp sockets用于排队缓冲数据报的页面量。

一般情况下这些值是在系统启动时根据系统内存数量计算得到的。

缺省设置:24576 32768 49152

28) /proc/sys/net/ipv4/tcp_app_win 该文件表示保留max(window/2^tcp_app_win, mss)数量的窗口由于应用缓冲。当为0时表示不需要缓冲。 缺省设置:31

29) /proc/sys/net/ipv4/tcp_adv_win_scale 该文件表示计算缓冲开销bytes/2^tcp_adv_win_scale(如果tcp_adv_win_scale >; 0)或者 bytes-bytes/2^(-tcp_adv_win_scale)(如果tcp_adv_win_scale <= 0)。 缺省设置:2

6.4 IP Variables 1) /proc/sys/net/ipv4/ip_local_port_range 该文件表示TCP/UDP协议打开的本地端口号。 缺省设置:1024 4999 建议设置:32768 61000

2) /proc/sys/net/ipv4/ip_nonlocal_bind 该文件表示是否允许进程邦定到非本地地址。 缺省设置:0

3) /proc/sys/net/ipv4/ip_dynaddr 该参数通常用于使用拨号连接的情况,可以使系统动能够立即改变ip包的源地址为该ip地址, 同时中断原有的tcp对话而用新地址重新发出一个syn请求包,开始新的tcp对话。 在使用ip欺骗时,该参数可以立即改变伪装地址为新的ip地址。该文件表示是否允许动态地址, 如果该值非0,表示允许;如果该值大于 1,内核将通过log记录动态地址重写信息。 缺省设置:0

4) /proc/sys/net/ipv4/icmp_echo_ignore_all/proc/sys/net/ipv4/icmp_echo_ignore_broadcasts 该文件表示内核是否忽略所有的ICMP ECHO请求,或忽略广播和多播请求。 0, 响应请求 1, 忽略请求 缺省设置:0 建议设置:1

5) /proc/sys/net/ipv4/icmp_ratelimit 6) /proc/sys/net/ipv4/icmp_ratemask 7) /proc/sys/net/ipv4/icmp_ignore_bogus_error_reponses 某些路由器违背RFC1122标准,其对广播帧发送伪造的响应来应答。 这种违背行为通常会被以告警的方式记录在系统日志中。如果该选项设置为True,内核不会记录这种警告信息。 缺省设置:0

8) /proc/sys/net/ipv4/igmp_max_memberships 该文件表示多播组中的最大成员数量。 缺省设置:20

6.5 Other Configuration 1) /proc/sys/net/ipv4/conf/*/accept_redirects 1表示接收这类重定向icmp 信息 0表示忽略。在充当路由器的linux主机上缺省值为0,在一般的linux主机上缺省值为1。 建议将其改为0以消除安全性隐患。

2) /proc/sys/net/ipv4/*/accept_source_route 是否接受含有源路由信息的ip包。参数值为布尔值,1表示接受,0表示不接受。在充当网关的linux主机上缺省值为1, 在一般的linux主机上缺省值为0。从安全性角度出发,建议关闭该功能。

3) /proc/sys/net/ipv4/*/secure_redirects 其实所谓的“安全重定向”就是只接受来自网关的“重定向”icmp包。该参数就是用来设置“安全重定向”功能的。 参数值为布尔值,1表示启用,0表示禁止,缺省值为启用。

4) /proc/sys/net/ipv4/*/proxy_arp 设置是否对网络上的arp包进行中继。参数值为布尔值,1表示中继,0表示忽略, 缺省值为0。该参数通常只对充当路由器的linux主机有用。

性能优化策略

7.1 基本优化 1) 关闭后台守护进程 系统安装完后,系统会默认启动一些后台守护进程,有些进程并不是必需的;因此,关闭这些进程可以节省一部分物理内存消耗。 以root身份登录系统,运行ntsysv,选中如下进程:

iptables network syslog random apmd xinetd vsftpd crond local 修改完后,重新启动系统。如此,系统将仅仅启动选中的这些守护进程。

2) 减少终端连接数 系统默认启动6个终端,而实际上只需启动3个即可;以root身份登录系统,运行vi /etc/inittab,修改成如下: # Run gettys in standard runlevels 1:2345:respawn:/sbin/mingetty tty1 2:2345:respawn:/sbin/mingetty tty2 3:2345:respawn:/sbin/mingetty tty3 #4:2345:respawn:/sbin/mingetty tty4 #5:2345:respawn:/sbin/mingetty tty5 #6:2345:respawn:/sbin/mingetty tty6 如上所述,注释掉4、5、6终端。

3) 待续。。。

7.2 网络优化

1) 优化系统套接字缓冲区 net.core.rmem_max=16777216 net.core.wmem_max=16777216

2) 优化TCP接收/发送缓冲区 net.ipv4.tcp_rmem=4096 87380 16777216 net.ipv4.tcp_wmem=4096 65536 16777216

3) 优化网络设备接收队列 net.core.netdev_max_backlog=3000

4) 关闭路由相关功能 net.ipv4.conf.lo.accept_source_route=0 net.ipv4.conf.all.accept_source_route=0 net.ipv4.conf.eth0.accept_source_route=0 net.ipv4.conf.default.accept_source_route=0 net.ipv4.conf.lo.accept_redirects=0 net.ipv4.conf.all.accept_redirects=0 net.ipv4.conf.eth0.accept_redirects=0 net.ipv4.conf.default.accept_redirects=0 net.ipv4.conf.lo.secure_redirects=0 net.ipv4.conf.all.secure_redirects=0 net.ipv4.conf.eth0.secure_redirects=0 net.ipv4.conf.default.secure_redirects=0 net.ipv4.conf.lo.send_redirects=0 net.ipv4.conf.all.send_redirects=0 net.ipv4.conf.eth0.send_redirects=0 net.ipv4.conf.default.send_redirects=0

5) 优化TCP协议栈 打开TCP SYN cookie选项,有助于保护服务器免受SyncFlood攻击。 net.ipv4.tcp_syncookies=1

打开TIME-WAIT套接字重用功能,对于存在大量连接的Web服务器非常有效。 net.ipv4.tcp_tw_recyle=1 net.ipv4.tcp_tw_reuse=1

减少处于FIN-WAIT-2连接状态的时间,使系统可以处理更多的连接。 net.ipv4.tcp_fin_timeout=30

减少TCP KeepAlive连接侦测的时间,使系统可以处理更多的连接。 net.ipv4.tcp_keepalive_time=1800

增加TCP SYN队列长度,使系统可以处理更多的并发连接。 net.ipv4.tcp_max_syn_backlog=8192

性能优化技巧

Neighbour table overflow处理

[root@test root]# ping www.163.com connect: No buffer space available

内核维护的arp表过于庞大, 发生抖动, 因此导致了这种情况 几个内核ARP参数: gc_stale_time 决定检查一次相邻层记录的有效性的周期。当相邻层记录失效时,将在给它发送数据前,再解析一次。缺省值是60秒。

gc_thresh1 存在于ARP高速缓存中的最少层数,如果少于这个数,垃圾收集器将不会运行。缺省值是128。

gc_thresh2 保存在 ARP 高速缓存中的最多的记录软限制。垃圾收集器在开始收集前,允许记录数超过这个数字 5 秒。缺省值是 512。

gc_thresh3 保存在 ARP 高速缓存中的最多记录的硬限制,一旦高速缓存中的数目高于此,垃圾收集器将马上运行。缺省值是1024。

比如arp -an|wc -l的结果是300左右, 那么应当调高gc_thresh各项数值,防止抖动的发生: echo “512″ > /proc/sys/net/ipv4/neigh/default/gc_thresh1 echo “2048″ > /proc/sys/net/ipv4/neigh/default/gc_thresh2 echo “10240″ > /proc/sys/net/ipv4/neigh/default/gc_thresh3

/proc/sys/net/ipv4/下各项的意义

/proc/sys/net/ipv4/icmp_timeexceed_rate

这个在traceroute时导致著名的“Solaris middle star”。这个文件控制发送ICMP Time Exceeded消息的比率。

/proc/sys/net/ipv4/igmp_max_memberships

主机上最多有多少个igmp (多播)套接字进行监听。

/proc/sys/net/ipv4/inet_peer_gc_maxtime

Add a little explanation about the inet peer storage? Minimum interval between garbage collection passes. This interval is in effect under low (or absent) memory pressure on the pool. Measured in jiffies.

/proc/sys/net/ipv4/inet_peer_gc_mintime

每一遍碎片收集之间的最小时间间隔。当内存压力比较大的时候,调整这个间隔很有效。以jiffies计。

/proc/sys/net/ipv4/inet_peer_maxttl

entries的最大生存期。在pool没有内存压力的情况下(比如,pool中entries的数量很少的时候),未使用的entries经过一段时间就会过期。

/proc/sys/net/ipv4/inet_peer_minttl

entries的最小生存期。应该不小于汇聚端分片的生存期。当pool的大小不大于inetpeerthreshold时,这个最小生存期必须予以保证。

/proc/sys/net/ipv4/inet_peer_threshold

The approximate size of the INET peer storage. Starting from this threshold entries will be thrown aggressively. This threshold also determines entries’ time-to-live and time intervals between garbage collection passes. More entries, less time-to-live, less GC interval.

/proc/sys/net/ipv4/ip_autoconfig

这个文件里面写着一个数字,表示主机是否通过RARP、BOOTP、DHCP或者其它机制取得其IP配置。否则就是0。

/proc/sys/net/ipv4/ip_default_ttl

数据包的生存期。设置为64是安全的。如果你的网络规模巨大就提高这个值。不要因为好玩而这么做——那样会产生有害的路由环路。实际上,在很多情况下你要考虑能否减小这个值。

/proc/sys/net/ipv4/ip_dynaddr /proc/sys/net/ipv4/icmp_destunreach_rate

如果你有一个动态地址的自动拨号接口,就得设置它。当你的自动拨号接口激活的时候,本地所有没有收到答复的TCP套接字会重新绑定到正确的地址上。这可以解决引发拨号的套接字本身无法工作,重试一次却可以的问题。

/proc/sys/net/ipv4/ip_forward

内核是否转发数据包。缺省禁止。

/proc/sys/net/ipv4/ip_local_port_range

用于向外连接的端口范围。缺省情况下其实很小:1024到4999。

/proc/sys/net/ipv4/ip_no_pmtu_disc

如果你想禁止“沿途MTU发现”就设置它。“沿途MTU发现”是一种技术,可以在传输路径上检测出最大可能的MTU值。

/proc/sys/net/ipv4/ipfrag_high_thresh

用于IP分片汇聚的最大内存用量。分配了这么多字节的内存后,一旦用尽,分片处理程序就会丢弃分片。

/proc/sys/net/ipv4/ip_nonlocal_bind

如果你希望你的应用程序能够绑定到不属于本地网卡的地址上时,设置这个选项。如果你的机器没有专线连接(甚至是动态连接)时非常有用,即使你的连接断开,你的服务也可以启动并绑定在一个指定的地址上。

/proc/sys/net/ipv4/ipfrag_low_thresh

用于IP分片汇聚的最小内存用量。

/proc/sys/net/ipv4/ipfrag_time

IP分片在内存中的保留时间(秒数)。

/proc/sys/net/ipv4/tcp_abort_on_overflow

一个布尔类型的标志,控制着当有很多的连接请求时内核的行为。启用的话,如果服务超载,内核将主动地发送RST包。

/proc/sys/net/ipv4/tcp_fin_timeout

如果套接字由本端要求关闭,这个参数决定了它保持在FIN-WAIT-2状态的时间。对端可以出错并永远不关闭连接,甚至意外当机。

缺省值是60秒。2.2内核的通常值是180秒,你可以按这个设置,但要记住的是,即使你的机器是一个轻载的WEB服务器,也有因为大量的死套接字而内存溢出的风险,FIN-WAIT-2的危险性比FIN-WAIT-1要小,因为它最多只能吃掉1.5K内存,但是它们的生存期长些。参见tcpmaxorphans。

/proc/sys/net/ipv4/tcp_keepalive_time

当keepalive起用的时候,TCP发送keepalive消息的频度。缺省是2小时。

/proc/sys/net/ipv4/tcp_keepalive_intvl

当探测没有确认时,重新发送探测的频度。缺省是75秒。

/proc/sys/net/ipv4/tcp_keepalive_probes

在认定连接失效之前,发送多少个TCP的keepalive探测包。缺省值是9。这个值乘以tcpkeepaliveintvl之后决定了,一个连接发送了keepalive之后可以有多少时间没有回应。

/proc/sys/net/ipv4/tcp_max_orphans

系统中最多有多少个TCP套接字不被关联到任何一个用户文件句柄上。如果超过这个数字,孤儿连接将即刻被复位并打印出警告信息。这个限制仅仅是为了防止简单的DoS攻击,你绝对不能过分依靠它或者人为地减小这个值,更应该增加这个值(如果增加了内存之后)。

注意:每个孤儿套接字最多能够吃掉你64K不可交换的内存。

/proc/sys/net/ipv4/tcp_orphan_retries

本端试图关闭TCP连接之前重试多少次。缺省值是7,相当于50秒~16分钟(取决于RTO)。如果你的机器是一个重载的WEB服务器,你应该考虑减低这个, 因为这样的套接字会消耗很多重要的资源。参见tcpmaxorphans。

/proc/sys/net/ipv4/tcp_max_syn_backlog

记录的那些尚未收到客户端确认信息的连接请求的最大值。对于有128M内存的系统而言,缺省值是1024,小内存的系统则是128。如果服务器不堪重负,试试提高这个值。注意!如果你设置这个值大于1024,最好同时调整include/net/tcp.h中的TCPSYNQHSIZE,以保证TCPSYNQHSIZE*16 ≤tcpmaxsyn_backlo,然后重新编译内核。

/proc/sys/net/ipv4/tcp_max_tw_buckets

系统同时保持timewait套接字的最大数量。如果超过这个数字,time-wait套接字将立刻被清除并打印警告信息。这个限制仅仅是为了防止简单的DoS攻击,你绝对不能过分依靠它或者人为地减小这个值,如果网络实际需要大于缺省值,更应该增加这个值(如果增加了内存之后)。

/proc/sys/net/ipv4/tcp_retrans_collapse

为兼容某些糟糕的打印机设置的“将错就错”选项。再次发送时,把数据包增大一些,来避免某些TCP协议栈的BUG。

/proc/sys/net/ipv4/tcp_retries1

在认定出错并向网络层提交错误报告之前,重试多少次。缺省设置为RFC规定的最小值:3,相当于3秒~8分钟(取决于RIO)。

/proc/sys/net/ipv4/tcp_retries2

在杀死一个活动的TCP连接之前重试多少次。RFC 1122规定这个限制应该长于100秒。这个值太小了。缺省值是15,相当于13~30分钟(取决于RIO)。

/proc/sys/net/ipv4/tcp_rfc1337

这个开关可以启动对于在RFC1337中描述的“tcp的time-wait暗杀危机”问题的修复。启用后,内核将丢弃那些发往time-wait状态TCP套接字的RST包。缺省为0。

/proc/sys/net/ipv4/tcp_sack

特别针对丢失的数据包使用选择性ACK,这样有助于快速恢复。

/proc/sys/net/ipv4/tcp_stdurg

使用TCP紧急指针的主机需求解释。因为绝大多数主机采用BSD解释,所以如果你在Linux上打开它,可能会影响它与其它机器的正常通讯。缺省是FALSE。

/proc/sys/net/ipv4/tcp_syn_retries

在内核放弃建立连接之前发送SYN包的数量。

/proc/sys/net/ipv4/tcp_synack_retries

为了打开对端的连接,内核需要发送一个SYN并附带一个回应前面一个SYN的ACK。也就是所谓三次握手中的第二次握手。这个设置决定了内核放弃连接之前发送SYN+ACK包的数量。

/proc/sys/net/ipv4/tcp_timestamps

时间戳可以避免序列号的卷绕。一个1Gbps的链路肯定会遇到以前用过的序列号。时间戳能够让内核接受这种“异常”的数据包。

/proc/sys/net/ipv4/tcp_tw_recycle

能够更快地回收TIME-WAIT套接字。缺省值是1。除非有技术专家的建议和要求,否则不应修改。

/proc/sys/net/ipv4/tcp_window_scaling

一般来说TCP/IP允许窗口尺寸达到65535字节。对于速度确实很高的网络而言这个值可能还是太小。这个选项允许设置上G字节的窗口大小,有利于在带宽*延迟很大的环境中使用。一旦内核认为它无法发包,就会丢弃这个包,并向发包的主机发送ICMP通知。

/proc/sys/net/ipv4/icmp_echo_ignore_all

根本不要响应echo包。请不要设置为缺省,它可能在你正被利用成为DoS攻击的跳板时可能有用。

/proc/sys/net/ipv4/icmp_echo_ignore_broadcasts [Useful]

如果你ping子网的子网地址,所有的机器都应该予以回应。这可能成为非常好用的拒绝服务攻击工具。设置为1来忽略这些子网广播消息。

/proc/sys/net/ipv4/icmp_echoreply_rate

设置了向任意主机回应echo请求的比率。

/proc/sys/net/ipv4/icmp_ignore_bogus_error_responses

设置它之后,可以忽略由网络中的那些声称回应地址是广播地址的主机生成的ICMP错误。

/proc/sys/net/ipv4/icmp_paramprob_rate

一个相对不很明确的ICMP消息,用来回应IP头或TCP头损坏的异常数据包。你可以通过这个文件控制消息的发送比率。

Linux AntiSpoofing方法

写个简单的脚本! 这样就应用到所有的interface上.

#!/bin/bash for i in /proc/sys/net/ipv4/conf/*/rp_filter do echo 1 > "$i" echo "$i" cat `echo "$i"` done

使用tmpfs加速服务器

tmpfs有以下优势

首先在/dev/shm建个tmp文件夹,然后与实际/tmp绑定

mkdir /dev/shm/tmp chmod 1777 /dev/shm/tmp mount --bind /dev/shm/tmp /tmp

设置可以直接在开机时挂载

none为挂载区域名称,defaults为预设 预设为使用物理内存的一半大小做RAMDISK 如果你希望自定义RAMDisk容量的大小,可以照以下例子作些修改来符合你的需求

none /tmp/session tmpfs defaults,size=64M 0 0

注意一下tmpfs在mount支持的参数size

#mount -t tmpfs -o size=300m tmpfs /tmp 挂载300m的tmpfs 到/tmp

#mount -t tmpfs -o size=50% tmpfs /tmp 挂载tmpfs到/tmp目录,大小为实际物理内存的一半

强制系统不使用swap分区

要想系统强制不使用 swap分区,那么: 将 /proc/sys/vm/swappiness 的值设置为0

echo 0 > /proc/sys/vm/swappiness

或者:

echo "vm.swappiness = 0" >> /etc/sysctl.conf sysctl -p # 立即生效

以上适用linux

提高 Linux 上 socket 性能

使用 Sockets API,我们可以开发客户机和服务器应用程序,它们可以在本地网络上进行通信,也可以通过 Internet 在全球范围内进行通信。

与其他 API 一样,您可以通过一些方法使用 Sockets API,从而提高 Socket 的性能,或者限制 Socket 的性能。

本文探索了 4 种使用 Sockets API 来获取应用程序的最大性能并对 GNU/Linux® 环境进行优化从而达到最好结果的方法。

详细见:http://www.ibm.com/developerworks/cn/linux/l-hisock.html

netfilter conntrack调优

netfilter在内核中有两个参数,我们要注意:

- conntrack_max conntrack最大数量

- hashsize 存储这些conntrack的hash表的大小

当conntrack入口数大于conntrack_max时,在hash表中每一个conntrack list中的存储的入口将不可控.

conntrack_mark/hashsize 为每个list所能存储的入口的数量 hash表存在于固定的的不可swap的内存中 conntrack_max决定占用多少这些不可swap的内存. conntrack_max=hashsize*8

缺省的hashsize, 在i386中

hashsize=conntrack_max/8=ramsize(in bytes)/131072=ramsize(in MegaBytes)8.

所以32位pc,512M内存可以存5121024^2/128/1024=512*8=4096(连接池list)

但是正确的算法是: hashsize=conntrack_max/8=ramsize(in bytes)/131072/(x/32) x表示使用的指针类型是(32位还是64的)

读取conntrack_max值

cat /proc/sys/net/ipv4/ip_conntrack_max

读取hashsize值

cat /proc/sys/net/ipv4/netfilter/ip_conntrack_buckets

你可修改这两个值以适应高负载的netfilter的应用

系统默认为conntrack_max:hashsize是8:1,你可以设成1:1以提高性能.

设置conntrack_max

echo $CONNTRACK_MAX > /proc/sys/net/ipv4/ip_conntrack_max

设置hashsize

如果(netfilter conntrack静态编译在内核中),2.4中可以在编译时设置,2.6可以在启动中(boot时)加入

ip_conntrack.hashsize=$hashsize

如果为modules,则可以使用 modprobe ip_conntrack hashsize=$hashsize

conntrack使用的内存计算

mem_used_by_conntrack(bytes)= CONNTRACK_MAX * sizeof(struct ip_conntrack) + HASHSIZE * sizeof(struct list_head)

其中

sizeof(struct ip_conntrack) 大概在192-352字节之间. sizeof(struct list_head) = 2 * size_of_a_pointer (i386中为4字节) = 8

一个例子512m内存,使用384m来用于conntrack则

38410241024/(352+8)(使用它是保守计算) =~1143901

(此为conntrack:hashszie为1:1,352为sizeof(ipconntrack),8为sizeof(listhead).

由于hash最好设为2的乘方的数,所以为1048576(2^20).

附相关设置及命令:

ip_conntrack timeout 原值432000秒(5天),可改为10小时

echo "600" > /proc/sys/net/ipv4/netfilter/ip_conntrack_tcp_timeout_established

ip_conntrack buffer使用情况

root@geminis# grep conn /proc/slabinfo ip_conntrack_expect 0 0 96 40 1 : tunables 120 60 8 : slabdata 0 0 0 ip_conntrack 605 1168 236 16 1 : tunables 120 60 8 : slabdata 73 73 3

修改linux相关限制ulimit

- ulimit 显示(或设置)用户可以使用的资源限制

- ulimit -a 显示用户可以使用的资源限制

- ulimit unlimited 不限制用户可以使用的资源,但本设置对可打开的最大文件数(max open files)和可同时运行的最大进程数(max user processes)无效。

- ulimit -n <可以同时打开的文件数> 设置用户可以同时打开的最大文件数(max open files)

- ulimit -u <可以运行的最大并发进程数> 设置用户可以同时运行的最大进程数(max user processes)

例如: ulimit -u 1024

例如:

ulimit -n 8192 如果本参数设置过小,对于并发访问量大的网站,可能会出现too many open files的错误

ulimit设置限制

可以把命令加到profile文件里,也可以在/etc/security/limits.conf文件中定义限制。

ulimit命令参数

-H 设置硬件资源限制. -S 设置软件资源限制. -a 显示当前所有的资源限制. -c size: 设置core文件的最大值.单位:blocks -d size: 设置数据段的最大值.单位:kbytes -f size: 设置创建文件的最大值.单位:blocks -l size: 设置在内存中锁定进程的最大值.单位:kbytes -m size: 设置可以使用的常驻内存的最大值.单位:kbytes -n size: 设置内核可以同时打开的文件描述符的最大值.单位:n -p size: 设置管道缓冲区的最大值.单位:kbytes -s size: 设置堆栈的最大值.单位:kbytes -t size: 设置CPU使用时间的最大上限.单位:seconds -u 进程数的上限 -v size: 设置虚拟内存的最大值.单位:kbytes

除可用ulimit命令设置外,也可以在/etc/security/limits.conf文件中定义限制。

domino type item value

- domino是以符号@开头的用户名或组名,*表示所有用户

- type设置为hard or soft

- item指定想限制的资源。如cpu,core nproc or maxlogins

- value是相应的限制值。

高并发网络负载linux的内核优化

我的理解

cat /proc/sys/net/ipv4/tcp_moderate_rcvbuf

如果这个参数为1(启用),则表示系统启用了自动调优设置,在这种模式下,每个TCP连接的接收数据(TCP Window Size)的大小是自动调整.

/proc/sys/net/ipv4/tcp_rmem - memory reserved for TCP rcv buffers /proc/sys/net/ipv4/tcp_wmem - memory reserved for TCP snd buffers

每个TCP连接所使用的默认内存空间,由三个数字组成,分别为minimum, initial and maximum buffer size. 注意:它们是控制实际的内存使用率,而不是TCP Window Size.

/proc/sys/net/core/rmem_max - maximum receive window /proc/sys/net/core/wmem_max - maximum send window

应用程序能够请求的最大缓存大小(即使用setsockopt() 系统调用的SOSNDBUF和SORCVBUF参数值 )

优化安全(kernel 2.6.17 && 1G 内存)

echo 1 > /proc/sys/net/ipv4/tcp_moderate_rcvbuf echo 108544 > /proc/sys/net/core/wmem_max echo 108544 > /proc/sys/net/core/rmem_max echo "4096 87380 4194304" > /proc/sys/net/ipv4/tcp_rmem echo "4096 16384 4194304" > /proc/sys/net/ipv4/tcp_wmem

查看程序占用内存映射

pmap -d pid

查看程序链接的系统调用与信号

strace -p/-f pid -o filename -t

查看网络路由情况

mtr -4nr -c50 -i0.1 ip

查看数据库性能

show full process list

show slow query

explain

set profiles